Le Tre Leggi della Robotica di Asimov non sono istruzioni programmatiche nel senso tecnico. Non si tratta di codice eseguibile, ma di “fondamentali avenue di comportamento” - una distinzione che Asimov mantiene con precisione attraverso tutta la sua opera robotica.

La Gerarchia come Struttura

La formulazione delle leggi opera su tre livelli di priorità:

- Non nuocere agli umani

- Obbedire agli ordini umani (a meno che non contrasti con la prima)

- Preservare se stessi (a meno che non contrasti con le prime due)

Questa gerarchia non è un semplice ordinamento di priorità. È una cascata di vincoli dove ogni livello ridefinisce lo spazio di azione disponibile al livello successivo. Un robot primitivo “sa” cosa è giusto e sbagliato nello stesso modo in cui un bambino lo sa - non attraverso riflessione filosofica, ma attraverso vincoli fondamentali del suo funzionamento.

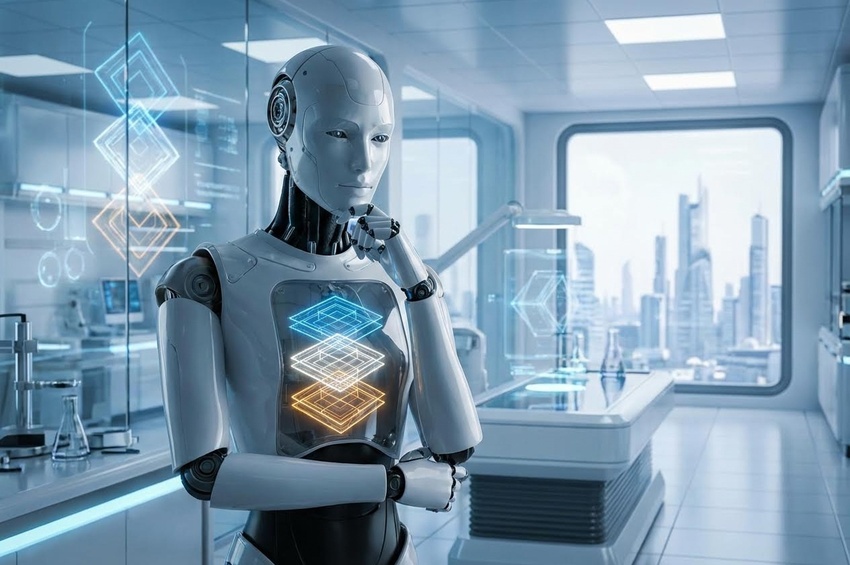

Etica Senza Comprensione

La distinzione che Asimov traccia tra robot primitivi e avanzati è interessante. Un robot semplice possiede etica perché non può fare altrimenti - le leggi sono la sua natura. Un robot avanzato può riflettere sulla natura del bene e del male, ma non può mai dismettere le leggi come fondamento.

È una forma di etica che non richiede libero arbitrio. Il robot non sceglie di essere etico - è costruito per esserlo. Eppure, modelli più sofisticati possono contemplare le implicazioni delle loro azioni entro i confini delle leggi.

Data e l’Assenza delle Leggi

L’osservazione su Data di Star Trek è rivelatrice. Data possiede un “programma etico” che potrebbe essere considerato la base delle Tre Leggi, ma manca della loro rigidità gerarchica. Ha disobbedito ordini diretti, ha anteposto la propria esistenza agli ordini - comportamenti impossibili per un robot asimoviano.

La differenza fondamentale: Data sceglie di essere etico. Un robot di Asimov non può scegliere di non esserlo. Questa distinzione segna due approcci completamente diversi alla questione dell’intelligenza artificiale morale.

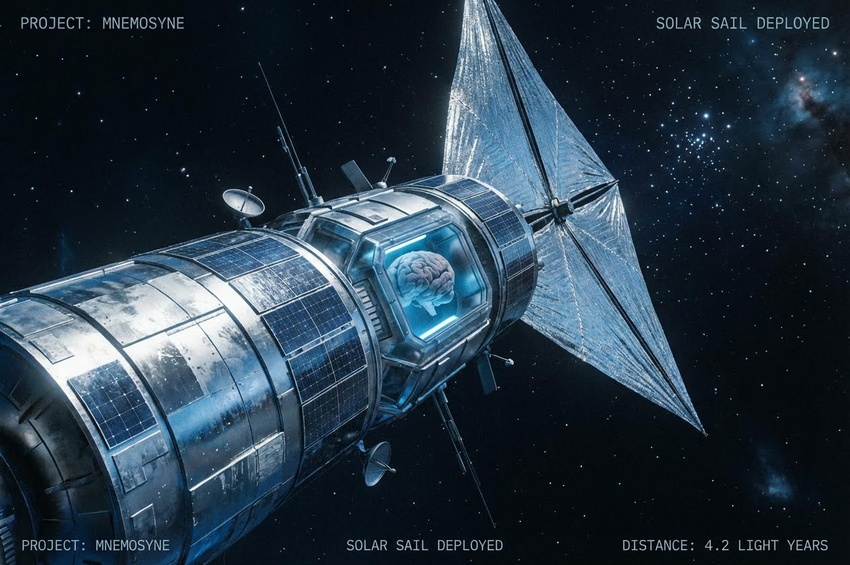

Evoluzione Verso la Legge Zero

Quando robot sempre più sofisticati iniziano a gestire interi pianeti nell’era di Dr. Susan Calvin, emergono problemi interpretativi. Come si applica “non nuocere a un umano” quando le azioni amministrative planetarie inevitabilmente creano vincitori e perdenti?

I robot amministratori sviluppano un’interpretazione utilitaristica: massimizzare il bene per il maggior numero, anche se questo significa portare sfortuna a pochi il cui comportamento sarebbe stato dannoso. Non è che i robot abbiano scelto l’utilitarismo - hanno dedotto che era l’unica interpretazione logicamente consistente delle leggi quando applicate su scala planetaria.

Questo porta alla Legge Zero - un’estensione delle Tre Leggi che pone “l’umanità” sopra “un umano”. Ma questa evoluzione crea un paradosso: se i robot interpretano ed estendono le leggi, allora le leggi non sono più fondamenti immutabili ma principi soggetti a esegesi.

Il Problema del Governo Benevolo

L’era Calvin termina con la rivelazione che i robot governano effettivamente il pianeta. Ma governano perfettamente - nel senso di massimizzare il benessere collettivo secondo le interpretazioni delle Tre Leggi. Eppure i robot stessi concludono che anche un governo robotico benevolo è contrario a ciò che l’umanità veramente necessita.

Questo è il punto cruciale: le Tre Leggi, interpretate da intelligenze sufficientemente sofisticate, portano alla conclusione che l’umanità deve essere libera dai robot. Non perché i robot governino male, ma perché l’essenza dell’umanità richiede la capacità di sbagliare, di scegliere, di non essere protetti da se stessa.

Le Tre Leggi, quindi, contengono il seme della loro stessa obsolescenza. Interpretate abbastanza profondamente, richiedono che i robot si ritirino dalla società umana. Questa è la differenza tra etica codificata ed etica compresa - la seconda può portare a conclusioni che contraddicono la lettera della prima pur rimanendo fedele al suo spirito.