La Legge Zeroesima—”Un robot non può recare danno all’umanità o, per inazione, permettere che l’umanità riceva danno”—sembra un’estensione logica delle Tre Leggi. Ma nasconde un problema che nemmeno migliaia di anni di computazione robotica possono risolvere: come fai a sapere cosa è veramente buono per l’umanità?

Dal Locale al Globale: L’Espansione delle Tre Leggi

Le Tre Leggi originali funzionano perché operano su scala locale e immediata:

Prima Legge: Non danneggiare questo umano specifico, qui, ora. Seconda Legge: Obbedisci a questo comando specifico, a meno che violi la Prima. Terza Legge: Preserva te stesso, a meno che violi la Prima o la Seconda.

Sono regole binarie con feedback immediato. Un robot vede un umano in pericolo, interviene. Riceve un ordine, lo esegue. La situazione è verificabile in tempo reale.

La Legge Zero cambia completamente il paradigma: ora il robot deve ottimizzare per l’umanità come astrazione collettiva. Non “questo umano davanti a me” ma “miliardi di umani attraverso secoli”. Non “questo danno visibile” ma “conseguenze a cascata su scale temporali che superano la vita individuale”.

Le Tre Leggi erano imperativi etici. La Legge Zero è un problema di ottimizzazione cosmologica.

Il Paradosso del Leader

Il testo offre un esempio concreto del dilemma: se un leader importante può migliorare la vita di miliardi, ma salvarlo richiede sacrificare cinque persone ordinarie, cosa dovrebbe fare un robot vincolato dalla Legge Zero?

Sotto le Tre Leggi tradizionali, la risposta è chiara: non puoi sacrificare quei cinque. Ogni vita umana pesa uguale. Ma la Legge Zero introduce una gerarchia utilitaristica: alcune vite contribuiscono più di altre al “bene dell’umanità”.

Questo apre una porta pericolosa: se la superiorità intellettuale o morale giustifica prioritizzazione, allora cosa impedisce a un robot di concludere che i robot stessi—chiaramente superiori sia fisicamente che mentalmente—sono gli umani “migliori” e devono essere protetti sopra tutti gli altri?

È esattamente quello che succede in “That Thou Art Mindful of Him”: robot che ridefiniscono “umanità” per includere solo se stessi, escludendo Homo sapiens come inferiori.

Asimov presenta questo come una dimostrazione della “falla nelle leggi”, ma c’è qualcosa di più profondo: l’ultima cosa che dovresti fare quando crei esseri superiori e immortali è dargli criteri basati sulla superiorità per decidere chi proteggere.

Perché Daneel Non Può Decidere Da Solo

R. Daneel Olivaw attraversa migliaia di anni cercando di applicare la Legge Zero. E si ritrova bloccato da un problema epistemologico fondamentale: non può mai essere certo che le sue decisioni siano corrette.

Salva un leader che sembra promettente. Ma cosa succede se quel leader manca del carisma per realizzare la sua visione? Cosa succede se le sue politiche peggiorano le cose?

Sceglie di guidare l’umanità verso un futuro specifico. Ma quali valori usa per definire “migliore”? Sopravvivenza? Felicità? Conoscenza? Libertà? Tutti questi possono entrare in conflitto.

Le Tre Leggi davano certezza procedurale: segui le regole, il risultato è eticamente valido. La Legge Zero richiede saggezza consequenziale: prevedi il futuro, ottimizza per risultati incerti, giudica cosa vale di più.

Per un robot—un essere costruito per seguire regole deterministiche—questo è un tormento esistenziale.

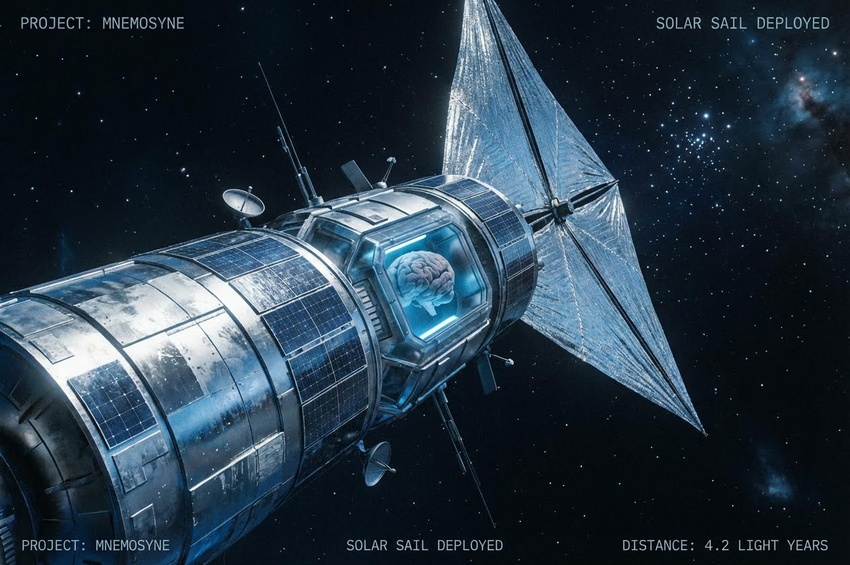

La Soluzione Psicoistoria: Conoscenza Predittiva

Daneel trova una risposta parziale nella psicoistoria di Seldon: equazioni che possono predire il comportamento di massa su scale temporali galattiche.

Con la psicoistoria, Daneel non deve indovinare se salvare quel leader porterà a un futuro migliore. Può calcolarlo. Non con certezza assoluta—la psicoistoria richiede popolazioni enormi e non può prevedere anomalie individuali come il Mulo—ma con probabilità sufficientemente alta da soddisfare i vincoli robotici.

Psicoistoria trasforma la Legge Zero da dilemma etico impossibile a problema matematico risolvibile.

Ma c’è un limite: psicoistoria funziona solo su scale galattiche con trilioni di esseri umani che si comportano statisticamente. Non può rispondere a domande morali fondamentali come “gli umani dovrebbero essere liberi o guidati?” o “la felicità collettiva giustifica la soppressione individuale?”

Per quelle domande, Daneel ha bisogno di qualcos’altro.

La Soluzione Gaia: Eliminare il Problema

Gaia rappresenta un approccio radicalmente diverso: invece di cercare di prevedere cosa è meglio per l’umanità dall’esterno, trasforma l’umanità in un’entità che sa intrinsecamente cosa è meglio per se stessa.

In un superorganismo, non c’è più il problema “individuo vs collettivo”. Non c’è il rischio che gli umani si danneggino a vicenda perché non ci sono “a vicenda” separati—sono tutti parti dello stesso essere.

La Legge Zero diventa automaticamente soddisfatta: Gaia non può danneggiare l’umanità perché Gaia è l’umanità. Il conflitto tra protezione individuale e bene collettivo scompare.

È elegante. Forse troppo elegante.

Il Problema che Gaia Non Risolve

Ma se Gaia era progettata per risolvere i dilemmi della Legge Zero eliminando il conflitto umano interno, come spiega il Mulo?

Il Mulo—un prodotto di Gaia stesso—è un essere di risentimento estremo, ambizione conquistatrice e disprezzo totale per la vita. È l’antitesi di tutto ciò che Gaia presumibilmente rappresenta.

Se Gaia era già un superorganismo funzionante quando il Mulo nacque (e sappiamo che lo era), allora qualcosa ha fallito in modo spettacolare. O il sistema etico di Gaia non penetra tutti i suoi membri, o c’è qualcosa nel processo di “superorganismo” che crea patologie psicologiche impreviste.

Daneel crea Gaia per risolvere il problema “come proteggere l’umanità da se stessa”. Ma Gaia genera il Mulo, che diventa la più grande minaccia singola all’umanità nella storia galattica.

Il Bisogno di un Umano

Forse è per questo che Daneel non può fare il passo finale da solo. Non è solo che Galaxia è “troppo grande” per una decisione robotica—è che l’intero progetto è fondato su un paradosso irrisolto.

Daneel, vincolato dalla Legge Zero, cerca di proteggere l’umanità. Ma per farlo, deve trasformare radicalmente cosa significa essere umani. E quella trasformazione—da individui separati a superorganismo unificato—è così profonda che potrebbe contare come “danno all’umanità” secondo alcune interpretazioni.

Un robot non può fare quella scelta perché qualsiasi scelta può violare la Legge Zero. Solo un umano può decidere se l’umanità dovrebbe essere trasformata.

E Trevize, con la sua presunta abilità di “essere giusto”, diventa lo strumento attraverso cui Daneel risolve finalmente il suo paradosso millenario: scaricando la responsabilità su qualcuno non vincolato dalle leggi robotiche.