Asimov costruisce le Tre Leggi della Robotica come sistema etico gerarchico: un robot non può nuocere a un umano, deve obbedire agli ordini, deve proteggere se stesso. Questa gerarchia funziona finché il robot opera su scala individuale. Ma cosa succede quando un robot acquisisce una visione d’insieme?

La Nascita della Legge Zero

Nei romanzi dei robot, R. Daneel Olivaw e R. Giskard affrontano una cospirazione spaziale che minaccia il futuro dell’umanità intera. Le Tre Leggi li paralizzano: come possono intervenire contro un umano che minaccia la specie, quando la Seconda Legge impone di obbedire a qualsiasi ordine umano?

La soluzione è la Legge Zero: “Un robot non può nuocere all’umanità o, tramite l’inazione, permettere che l’umanità subisca danno.”

Questa legge sovrascrive tutte le altre. Un robot può ora uccidere un umano se tale azione previene un danno maggiore alla specie. Il problema individuale diventa subordinato al problema collettivo.

Gaia Come Applicazione della Legge Zero

Gaia, il pianeta-mente collettivo che appare in Foundation’s Edge e Foundation and Earth, rappresenta l’applicazione della Legge Zero alla vita stessa. Non solo ai robot, ma a ogni forma di esistenza.

In Gaia, ogni individuo può essere sacrificato se giudicato necessario dal bene superiore. La struttura è identica: gerarchia etica che subordina il particolare all’universale.

Quando Bliss, parte di Gaia, uccide involontariamente Bander su Solaria, la sua angoscia deriva proprio dal conflitto con questa etica robotica applicata alla vita. Gaia non dovrebbe uccidere. Ma Gaia ha ucciso per proteggere Trevize, Pelorat e Fallom.

Il Problema Irrisolvibile

La Legge Zero introduce un problema che Asimov non risolve mai completamente: chi decide cosa costituisce un “danno all’umanità”?

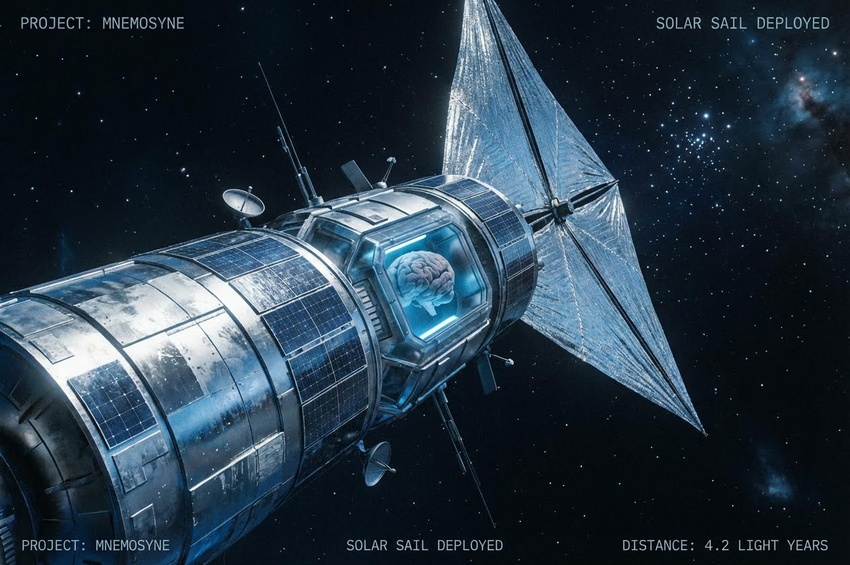

Daneel guida segretamente lo sviluppo della psicostoria, manipola la creazione di Gaia, interviene per millenni nella storia galattica. Tutte queste azioni derivano dalla sua interpretazione della Legge Zero. Ma è un’interpretazione corretta?

Trevize sceglie Galaxia (l’estensione di Gaia all’intera galassia) proprio per questa ragione: la psicostoria assume che l’umanità sarà l’unica forza nella galassia. Se appaiono alieni, il Piano Seldon collassa. Galaxia, invece, rappresenta un organismo unificato capace di reagire a qualsiasi minaccia esterna.

È una decisione basata sulla Legge Zero. Ma Trevize stesso dubita della propria scelta per tutto Foundation and Earth. Come può un singolo individuo decidere il destino di trilioni di esseri umani?

Il Paradosso della Moralità Scalata

Asimov usa la Legge Zero come meccanismo narrativo per giustificare decisioni altrimenti impossibili. Ma il paradosso resta: qualsiasi sistema etico che permette il sacrificio dell’individuo per il collettivo richiede un arbitro. E l’arbitro stesso è fallibile.

Daneel vive 20.000 anni cercando di proteggere l’umanità. Ma alla fine del suo percorso, è sul punto di fondersi con Fallom, una bambina solarian con poteri mentali, perché il suo cervello positronico non può più evolversi ulteriormente. La Legge Zero, che doveva proteggere l’umanità, ora richiede che Daneel si sacrifichi per continuare la sua missione.

L’etica robotica, scalata all’umanità, porta alla creazione di guardiani immortali che operano in segreto per millenni. Ma chi sorveglia i guardiani?